首先我们需要创建一个新的虚拟环境,并将GitHub的内容克隆到本地。 conda create -n XtunerGUI python=3.10 -y conda activate XtunerGUI git clone https://github.com/scchy/XtunerGUI.git 然后我们需要进入仓库的内部并安装运行XTunerGUI所需要的包(假如安装速度过慢请使用清华源镜像)。 cd XtunerGUI pip instal...

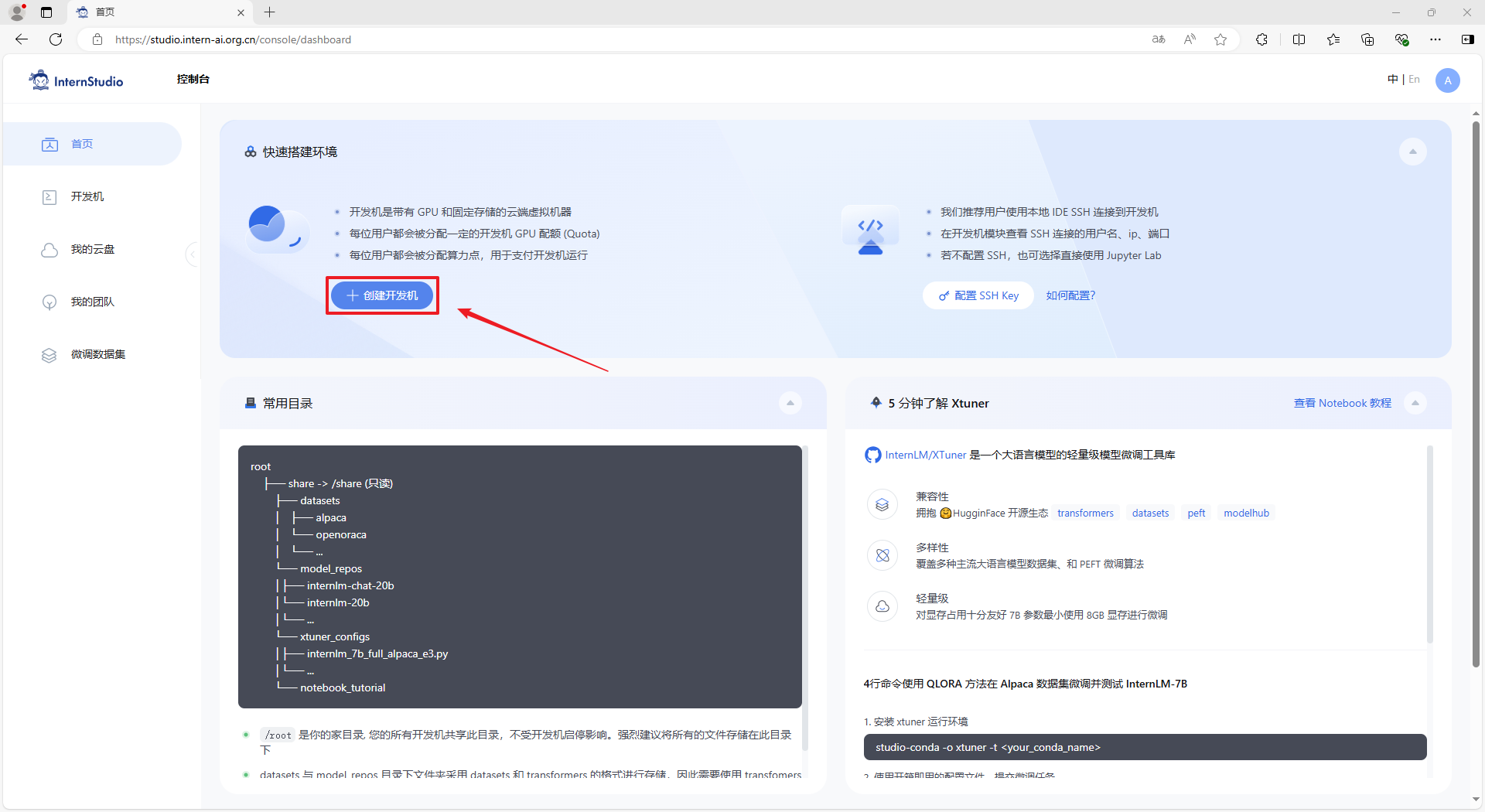

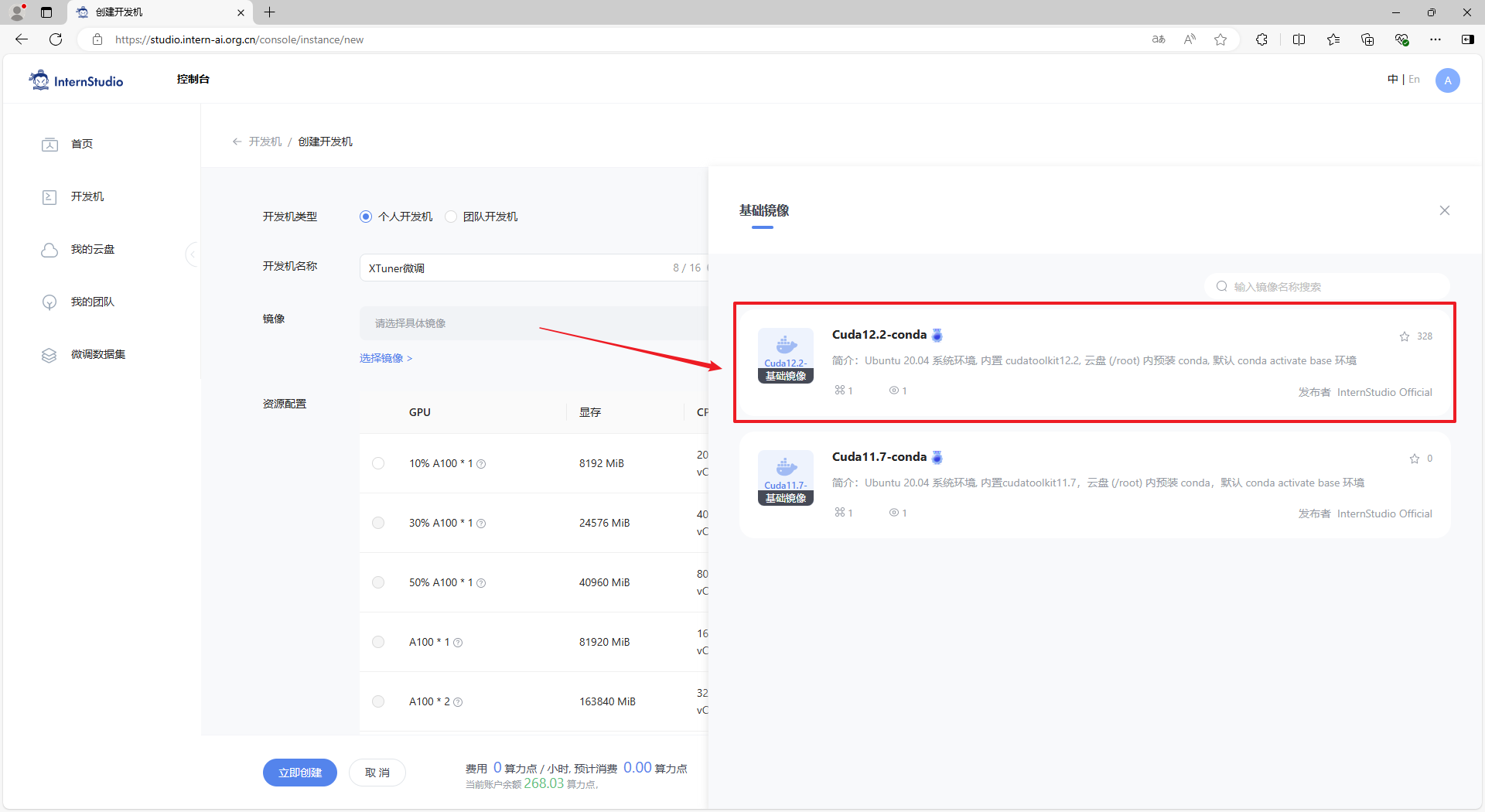

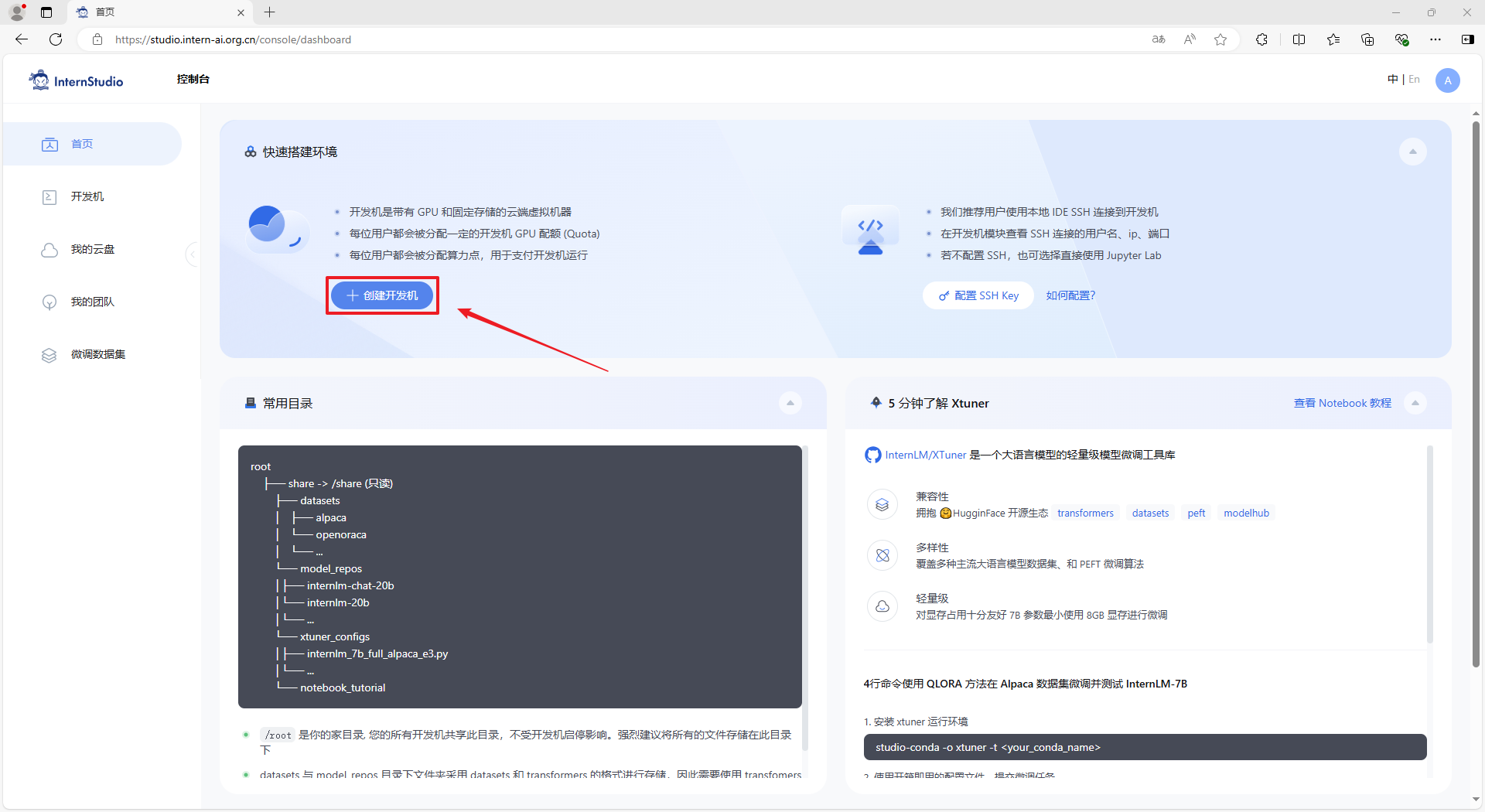

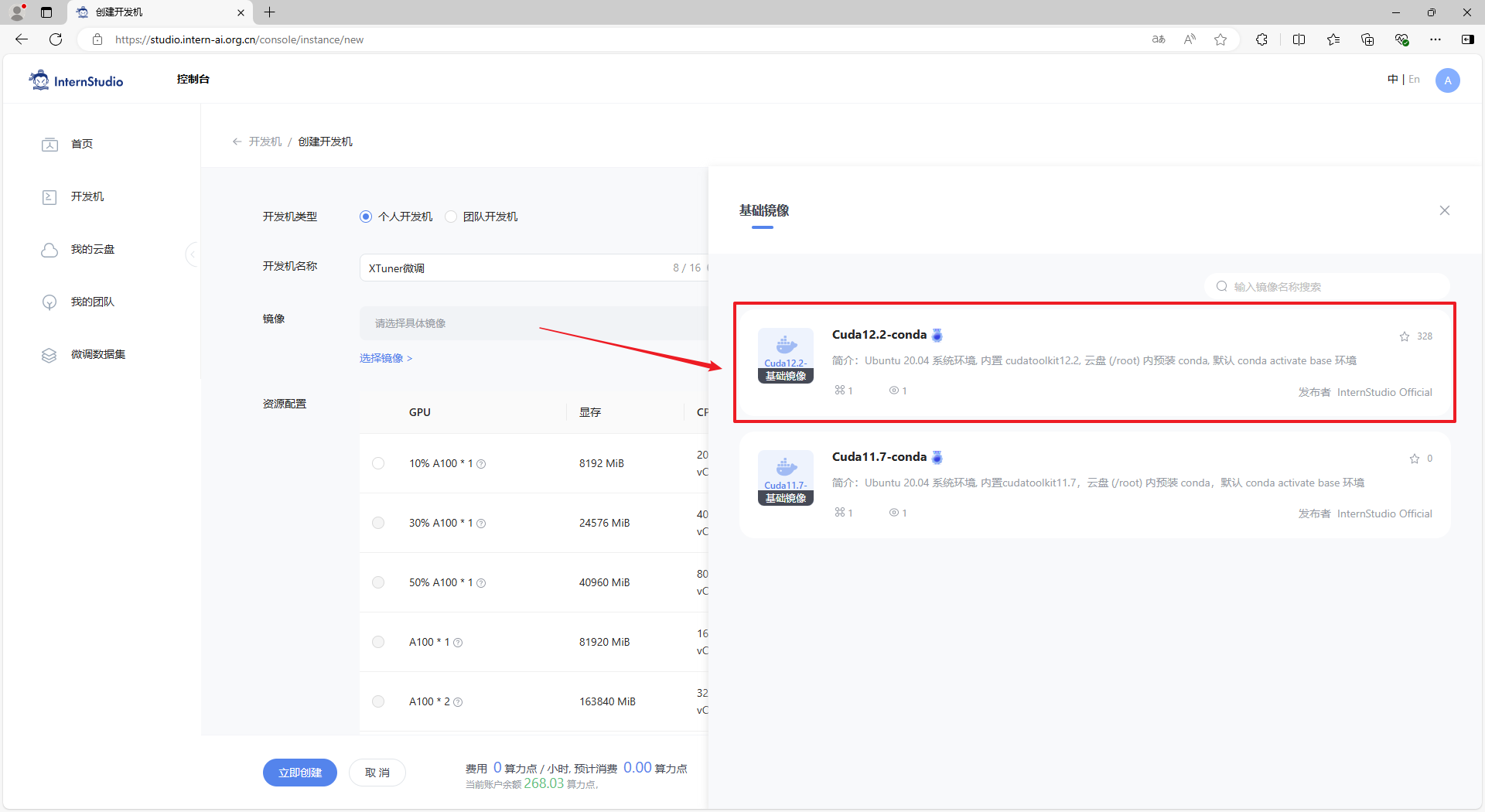

步骤2:在 “创建开发机” 界面,选择开发机类型:个人开发机,输入开发机名称:XTuner微调,选择开发机镜像:Cuda12.2-conda。  ...

数据准备:https://github.com/InternLM/xtuner/blob/main/docs/zh_cn/user_guides/dataset_prepare.md 数据集格式:https://github.com/InternLM/xtuner/blob/main/docs/zh_cn/user_guides/dataset_format.md 4. 配置文件 简介 官方文档:https://github.com/InternLM/xtuner/blob/main/docs/zh_cn/user_guides...

首先,从 Github 上下载源码。 ```bash git clone -b v0.1.21 https://github.com/InternLM/xtuner # 创建一个目录,用来存放源代码 mkdir -p /root/InternLM/code cd /root/InternLM/code git clone -b v0.1.21 https://github.com/InternLM/XTuner ``` 其次,进入源码目录,执行安装。 > 如果速度太...

首先从github上下载源码。 进入源码目录,进行安装。 4.模型准备 创建一个目录,存放微调的所有资料,后续的所有操作都在该目录进行,同时通过符号链接的方式链接到模型文件。 此操作后,Shanghai_AI_Laboratory/internlm2-chat-1_8b直接成为一个符号链接,这个链接指向/root/share/new_models/Shanghai_AI_Laboratory/inter...

git clone https://github.com/InternLM/xtuner.git cd xtuner pip install -e '.[all]' Fine-tune XTuner supports the efficient fine-tune (e.g., QLoRA) for LLMs. Dataset prepare guides can be found on dataset_prepare.md. Step 0, prepare the config. XTuner provides many ready-to-use ...

git clone -b v0.1.21 https://github.com/InternLM/XTuner /root/InternLM/code/XTuner # 进入到源码目录 cd /root/InternLM/code/XTuner conda activate xtuner0121 # 执行安装 pip install -e '.[deepspeed]' -i https://mirrors.aliyun.com/pypi/simple/ ...

git clone -b v0.1.21 https://github.com/InternLM/XTuner /root/InternLM/code/XTuner 其次,进入源码目录,执行安装。 # 进入到源码目录 cd /root/InternLM/code/XTuner conda activate xtuner0121 # 执行安装 pip install -e '.[deepspeed]'

步骤2:在 “创建开发机” 界面,选择开发机类型:个人开发机,输入开发机名称:XTuner微调,选择开发机镜像:Cuda12.2-conda。  ...

XTuner GitHub 链接: https://github.com/InternLM/xtunergithub.com/InternLM/xtuner InternLM-20B GitHub 链接: https://github.com/InternLM/InternLMgithub.com/InternLM/InternLM XTuner 大语言模型微调优化策略 在XTuner 中,一体化集成 QLoRA、DeepSpeed、Flash Attention 优化策略,可以实现在 24GB 显...